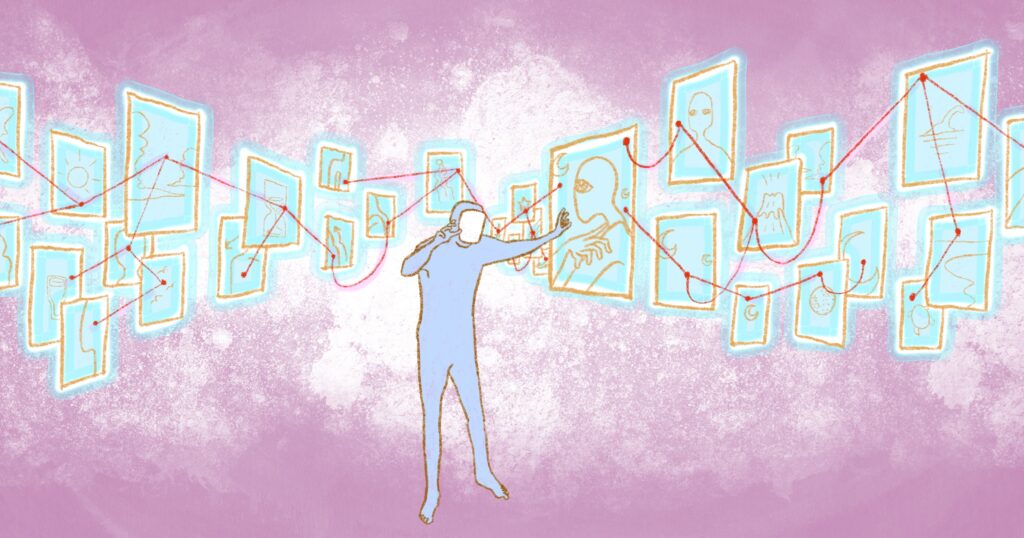

插画作者:Nodjadong Boonprasert

我们正接近一个“信噪比”趋近于一的临界点——这意味着,随着虚假信息的传播速度逐渐赶上真实信息,分辨信息真伪已变得越来越困难。这份指南旨在培训新闻工作者如何在截稿压力下识别 AI 生成的内容,并提供了七个每位新闻工作者都需要掌握的检测方法。

作为一名协助新闻机构打击虚假信息的从业者,最让我夜不能寐的是:传统的事实核查往往需要数小时甚至数天,而 AI 生成虚假信息只需几分钟。

视频虚假信息的历史非常久远,甚至早于现代 AI 技术几十年。即便受限于早期录像设备的技术水平,视频仍能制造出极具破坏力的错误假象。2003年,保姆克劳迪娅·穆罗(Claudia Muro)蒙冤入狱29个月,只因低帧率的监控摄像头将她原本温柔的动作拍得看似暴力,而当时没人想到去验证录像的真实性。到了2025年1月,英国教师谢丽尔·贝内特(Cheryl Bennett)因一段伪造她发表种族主义言论的“深度伪造”(deepfake)视频而被迫隐姓埋名。

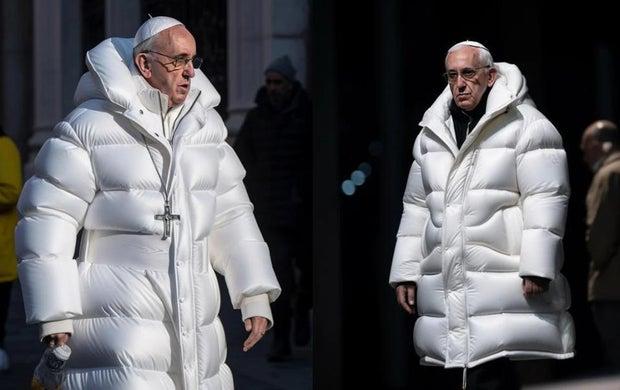

一张显示教宗方济各身穿巴黎世家的羽绒服的 AI 生成图。图:Midjourney, Pablo Xavier

这张教宗方济各身穿白色巴黎世家羽绒服的照片曾在社交媒体上疯传,欺骗了数百万网民,最终被证实是用 Midjourney 的“文生图”功能生成的 AI 图像。关键的破绽在于他胸前的十字架莫名其妙地悬在半空,且链条的另一半本该存在的地方却只有白色羽绒服。图像的创作者巴勃罗·沙维尔(Pablo Xavier)告诉 BuzzFeed 新闻:“我只是觉得看到教宗穿着滑稽的夹克很有趣。”

有时,最有效的伪造根本不需要 AI。2019年5月,一段美国众议院议长佩洛西(Nancy Pelosi)的视频被放慢至 75% 的速度并经过变调处理,让她看起来像是喝醉了。2018年11月,白宫分享了一段加速处理后的 CNN 记者吉姆·阿科斯塔(Jim Acosta)与白宫实习生互动的视频,让他原本的手臂动作看起来比实际情况更具攻击性。

最近,我在午休时间仅用了28分钟就制造了一起彻头彻尾的虚假政治丑闻——包括新闻主播、愤怒的市民、抗议画面以及那个虚构的市长本人。总成本是多少?8美元,28分钟,我就制造了一场完全虚构的政治危机,足以蒙骗那些在截稿压力下忙得焦头烂额的编辑。

不久前,我曾目睹一位经验丰富的事实核查员自信地宣布一张 AI 生成的图片是“真实”的,理由是图中的手是完美的五根手指,而不是六根。但现在,这种鉴别方法已基本失效。

这就是 AI 检测面临的残酷现实:那些曾让我们感到安全的方法正在眼皮底下消失。在 AI 图像生成器的早期发展阶段,画得很烂的手非常常见(比如多出的手指或粘连的指头),这些特征常被用来识别 AI 图像。像2023年疯传的“特朗普被捕”假照片,部分就是因为这些明显的手部错误而露馅的。然而,到了2025年,Midjourney 和 DALL-E 等主流 AI 模型在绘制结构准确的手部方面已有了显著提升。结果就是,手部特征不再是检测 AI 图像的可靠依据,想要识别 AI 艺术的人必须寻找其他更细微的线索。

文本渲染技术的变革甚至来得更快。曾经,AI 生成的抗议标语牌上满是诸如“STTPO THE MADNESSS”和“FREEE PALESTIME”这样的乱码,而现在的部分模型已能生成完美的排版。OpenAI 专门针对文本准确性训练了 DALL-E 3,Midjourney V6 也将“精准文本”作为一个卖点。这一曾经可靠的检测方法,如今已鲜有成效。

错位的耳朵、不自然的大小眼以及看起来像是画上去的牙齿,这些曾经区分 AI 人脸的特征正变得越来越罕见。2023年1月生成的人像经常出现肉眼可见的瑕疵,而如今同样的提示词已经能生成令人信以为真的面孔。

对新闻编辑室而言,这构成了根本性的危险。一名受过2023年检测方法培训的记者可能会产生盲目自信,仅仅因为某些内容通过了过时的测试,就将明显由 AI 生成的内容判定为真,这种错位的确定性比坦诚的不确定性更危险。

入门:Image Whisperer

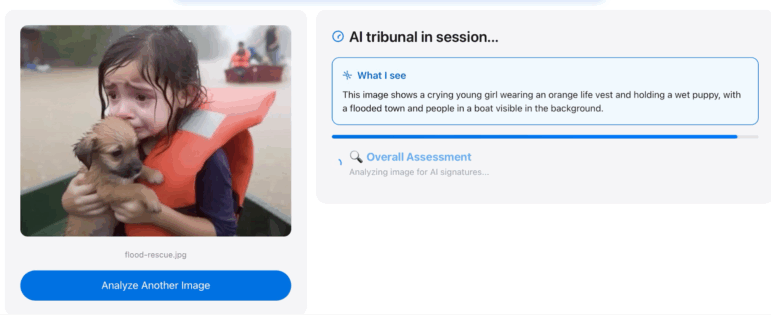

Image Whisperer 对一张声称显示美国洪灾后女孩获救的 AI 生成图像的分析。图:Henk van Ess

我曾想过,是否可以在这篇文章之外,附赠一个帮助识别 AI 内容的验证助手。于是我开始给专家发邮件。他们带我深入到了我未曾预料的物理领域:傅里叶变换、神经网络的量子力学,以及人眼无法察觉的数学特征。一位物理学家解释说,AI 产生的伪影不仅仅是视觉上的瑕疵——它们是频率域中的指纹。

但紧接着,现实给了我一记重击:“不要自己构建工具,”一位专家警告道,“你需要庞大的算力和博士级别的团队。没有这些基础设施,你只会惨败。”

就在那时,我突然想通了。为什么不用 AI 来对抗 AI,但换个思路呢?与其重新开发价值数十亿美元的检测系统,不如利用现有的 AI 基础设施来完成繁重的工作。

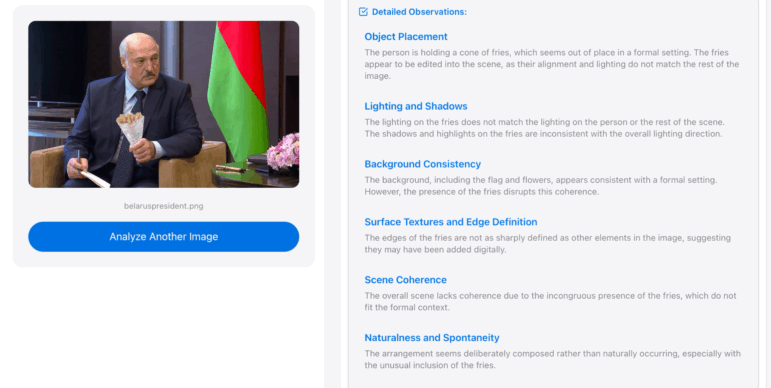

Image Whisperer 对一张声称显示白俄罗斯总统手持一筒薯条的 AI 生成图像分析。图:Henk van Ess

Image Whisperer(原名:Detectai.live)就是在这个理念下诞生的。该工具并行运行大语言模型分析与 Google Vision 处理,应用专家们教给我的物理学原理,同时利用现有的计算能力。最重要的是,与大多数 AI 工具不同,当它不知道时,它会如实告诉你,而不是瞎猜。

它并不希望成为市面上最好的 AI 生成图片检测系统——它希望成为最诚实的那个。

七大 AI 检测类别

AI 创作者与检测者之间的竞赛仍在继续,目前创作者占据速度优势。识别深度伪造(deepfake)正演变成一场猫鼠游戏,开发人员不断改进技术。成功识别深度伪造需要结合多种检测方法,保持时刻警惕,并接受“完美检测可能不存在”这一事实。对于寻求精确答案的记者来说,目标已经从“确切鉴定”转变为“概率评估”和“基于专业认知的编辑判断”。

但新闻业总是能适应技术的变迁。当任何人都能创建网站时,我们学会了核实信源;当每个人都成为潜在的报道者时,我们制定了社交媒体核查方法;现在,在这个任何人都能制造出令人信服的视听证据的时代,我们必须建立新的标准。

第一类:解剖学与物体的破绽:当完美成为破绽

View this post on Instagram

30秒危险信号检查(针对突发新闻): 当时间紧迫,你需要对那些可疑的“完美感”进行即时评估时,请相信你的直觉——如果有些东西看起来“好得令人难以置信”。在那些不可能或不适合如此精致的语境中,寻找杂志级别的审美。一位化着完美妆容的抗议领袖、一位发型完美的灾难受害者,或者一个每个人都像经过专业造型设计的抓拍政治时刻,都应立即引起你的怀疑。

- 完美感直觉检查 — 此人是否看起来过于精致/完美,不符合当前情况?

- 处境不匹配扫描 — 在危机/冲突场景中出现杂志级的美感?

- 皮肤真实度检查 — 本该有自然纹理的地方却呈现喷枪修图般的平滑?

- 整体修饰评估 — 外表是否符合场景设定?

五分钟技术核实(适用于常规报道): 这种更深入的检查侧重于那些暴露人工生成痕迹的技术细节。现代 AI 能生成解剖结构正确的图像,但它们往往表现出一种真实摄影中不存在的“诡异完美”。真人的面孔有微妙的不对称、自然的磨损痕迹和环境影响,而 AI 很难真实地复制这些。

- 面部放大至 100% — 寻找自然的皮肤纹理、毛孔和微小的不对称。

- 衣物纹理评估 — 是否存在自然的褶皱、织物纹理和磨损痕迹?

- 发丝分析 — 是一根根清晰可见的发丝,还是涂抹/渲染出来的外观?

- 珠宝/配饰真实感 — 是三维立体的外观,还是计算机图形般的扁平感?

- 牙齿检查 — 是否有自然的瑕疵,还是整齐划一的完美?

- 整体完美审计 — 修饰水平是否符合声称的语境和背景?

深度调查(适用于重磅报道): 对于准确性至关重要的报道,这种综合分析将图像视为需要法证级审查的证据,目标是建立基于多个验证点的概率评估,并理解虽然确凿的证据可能无法获得,但明智的判断却是可以实现的。

- 对比分析 — 找到同一个人的其他照片,对比自然与人工修饰的程度。

- 技术放大 — 使用专业工具在像素级别检查皮肤纹理的数学模式。

- 背景核实 — 研究并对比其他图像,确定该人在类似场合是否通常如此精致。

- 专业咨询 — 联系像哈尼·法里德(Farid Hany)这样的数字取证专家进行高级分析。

- 多角度验证 — 寻找同一事件的其他照片/视频以检查一致性。

- 历史比对 — 与同一时期和背景下该人经核实的照片进行比对。

第二类:违背几何物理学——当 AI 无视自然法则

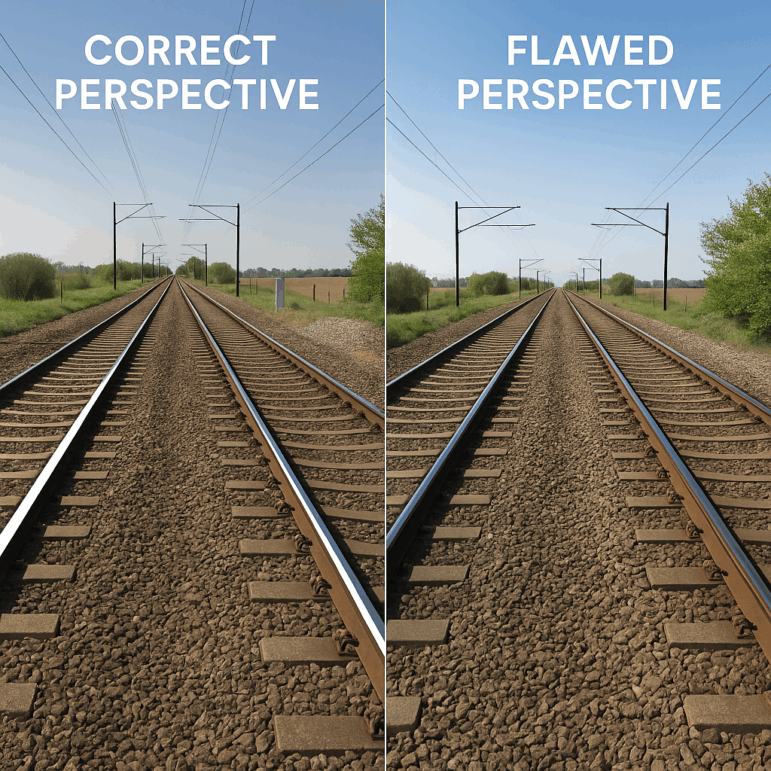

一张 AI 生成的铁轨向远处延伸的图像,与其并列的是一张具有正确透视关系的实景照片。图:Henk van Ess

原理: AI 像是一个拼贴艺术家,而不是摄影师。它理解视觉元素,但不理解现实世界中光线、透视和阴影运作的几何与物理规则。这些基本的物理错误对 AI 来说很难修正,因为这需要理解三维空间和光线行为。

AI 图像中的现实物理问题: 尽管我们仍处于生成式 AI 的早期阶段,但今天的 AI 生成图像已经在透视校正阴影和反射方面取得进展。一个使用 OpenAI DALL-E 2 生成的典型例子可能会显示不一致的阴影、完全不匹配或缺失的反射,以及反射中的阴影方向完全错误。

消失点分析: 真实的建筑物遵循透视法则——平行线会在地平线上的某一点汇聚。AI 经常生成的建筑物,其屋顶线指向左边,而窗户线却指向右边,这种物理上的不可能性揭示了它是算法拼凑而非摄影捕捉的结果。消失点对于捕捉真实图像中的透视本质至关重要,而生成的图像通常表现出线条未能汇聚在正确消失点上的不一致性。

阴影一致性检查: 有光的地方就有阴影。物体、阴影和照明光源之间的关系在几何上很简单,但在篡改或合成的图像中却极难做到完全正确。在单一光源场景(如阳光下),所有阴影必须指向该光源的相反方向。AI 经常显示只有太阳一个光源,但人们却投射出多个方向的阴影,这违反了基本的物理定律。

研究验证: 学术研究已经证实了这些几何缺陷。使用 GradCam 分析户外图像的研究揭示了车辆阴影方向各异,以及消失点附近的结构扭曲;而室内场景则显示出物体与阴影不匹配以及房间几何线条错位。

这种细微的差别并非一般人所能觉察,要习惯于先盯着线条看。

30秒危险信号检查:

- 找一张笔直的火车铁轨照片(谷歌搜索“railroad tracks perspective”)。

- 打开“画图”或任何基础图像编辑器。

- 使用线条工具描绘两条铁轨,将它们向地平线延伸。

- 检查它们是否汇聚于一点——这是应该发生的情况。

现在你掌握了正确透视外观的视觉模板。

五分钟技术核实(适用常规报道):

透视测试:

- 在图像中选择一栋建筑物。

- 使用任何图像编辑器画出延长的屋顶线和窗户行。

- 检查同一建筑物的线条是否汇聚于一点。

- 同一结构有多个消失点 = AI 拼凑错误。

阴影分析:

- 确定主光源(最亮的高光部分)。

- 画线从光源穿过物体顶部连接到阴影末端。

- 验证所有阴影是否指向同一方向。

- 阴影方向冲突 = 违反物理定律。

深度调查(适用重磅报道):

反射验证: 当物体反射在平面上时,连接物体上一点与反射中对应点的线条应汇聚于单一消失点。

- 在图像中寻找反射表面(水面、玻璃、镜子)。

- 画线连接物体与其反射影像。

- 检查线条是否以直角与反射表面相交。

- 不可能的反射位置 = 无效几何。

第三类:技术指纹与像素分析——数学层面的 DNA

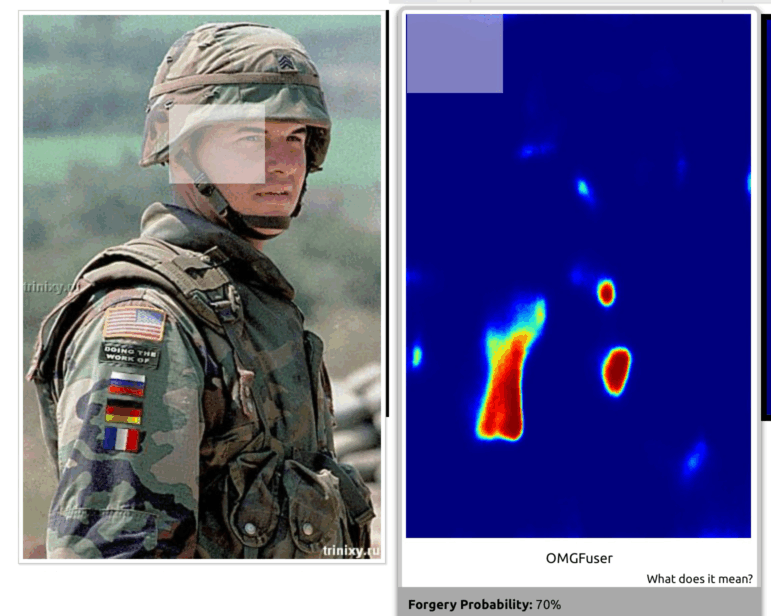

一张在网络疯传、经过数字篡改的2004年美军士兵照片。图片中被人为添加了“DOING THE WORK OF”字样的臂章,以及俄罗斯、德国和法国的国旗。工具展示了可能的篡改区域。图:Henk van Ess

原理: 当 AI 创建图像时,它会在文件中留下隐藏的线索——一种特殊的数学签名,就像隐形的指纹,只有通过专门的工具才能检测到。这些线索隐藏在像素的排列方式和文件的压缩方式中。这就好比 DNA 证据,能证明某样东西是由 AI 制造的,而非真实相机拍摄。

噪点模式检测: 真实相机拍摄的图像带有自然、杂乱的瑕疵——比如来自相机传感器的微小随机噪点。相反,AI 生成的图像则具有不自然的完美模式。当专家使用专门软件分析这些模式时,他们会看到真实照片中绝不会出现的独特星形图案。这就好比老式电视上真正随机的雪花点与计算机试图模拟的随机噪点之间的区别——如果你有合适的工具,就会发现伪造版本背后隐藏着某种特定的秩序,从而露馅。

复制粘贴检测: 当 AI 或人类复制图像区域时,会产生异常的像素相关性。不同的区域在空间冗余度之外变得异常相似,从而产生可检测的模式或数学签名。

压缩伪影分析: AI 生成的内容通常显示出不自然的压缩模式,这与相机生成的原始文件不同,揭示了其源于算法而非光学成像的本质。

专业检测工具: TrueMedia.org 的技术能够分析可疑媒体,并识别音频、图像和视频中的深度伪造(Deepfakes)。TrueMedia.org 最近标记的深度伪造案例包括一张所谓的特朗普被捕照片,以及一张所谓的拜登总统与高级军事人员的合影。

30秒危险信号检测:

在分析可疑图像之前,先拿一些简单的练练手:

- 将你的照片上传到图像验证助手(Image Verification Assistant)。

- 该技术将提供一个“伪造概率”。

- 当伪造概率达到 70% 或更高时,对图像进行进一步研究。

五分钟技术核实(适用于常规报道):

- 视觉纹理检查: 将皮肤或天空等区域放大到 100%。仔细观察纹理——它是否具有现实生活中那种随机、不规则的质感,还是看起来过于平滑、过于完美?真实照片拥有自然的混沌感;AI 经常生成可疑的统一模式。

- 自动化检测工具: 将图像上传到 TrueMedia.org(一个免费网站)。该工具会通过 AI 检测软件运行图像,分析我们之前提到的隐藏数学签名。它会给出一个百分比,以此判断图像由 AI 生成的可能性。

- 检查文件的隐藏信息: 右键单击图像文件并选择“属性”(PC)或“显示简介”(Mac)。查看元数据——这显示了创建文件的软件和时间。AI 图像通常会显示编辑软件的时间戳或创建工具,这些信息往往与照片声称的拍摄时间/方式不符。

- 表面平滑度分析: 这与纹理检查步骤不同。这里你要观察那些本该自然不完美的表面——如墙壁、织物或水面。AI 倾向于对这些表面进行“喷枪处理”(过度磨皮),使其变得不自然地平滑,而真实照片则会显示微小的凸起、变化或磨损。

每一步都能捕捉到不同类型的 AI 错误——这就好比使用多种不同的测试来确保你的结论万无一失。

深度调查(适用于重磅报道):

Forensically: 这是一套免费、全面的噪点分析工具,具有频域可视化功能。

频域分析(Frequency domain analysis): 对 AI 独有的数学模式进行技术检测。

第四类:声纹与音频伪影——合成语音的破绽

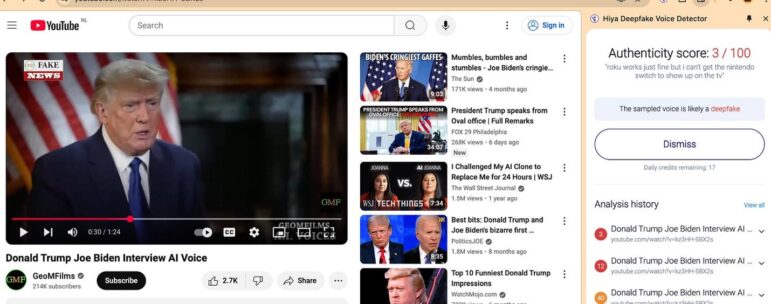

对特朗普 AI 深度伪造音频的分析。图:YouTube(经由 Henk van Ess)

原理: 声音克隆技术仅需几秒钟的音频素材就能复制任何人的声音,但它在语式模式、情感真实度和声学特征方面仍会留下人工生成的痕迹。虽然合成声音的准确度惊人,但在复制使语音真正真实的微妙人类元素方面,它仍然很吃力。

现实世界的音频欺诈案例: 2019年3月,一家英国能源公司的 CEO 接到了“老板”打来的电话,对方操着一口完美的德国口音,要求进行大额转账。直到这名 CEO 接到来自奥地利号码的第二个可疑电话,才揭穿了这场 AI 骗局。2024年,政治顾问史蒂文·克莱默(Steven Kramer)支付了150美元制作了一个模仿美国总统乔·拜登的深度伪造自动语音电话(robocall),敦促人们不要在2024年新罕布什尔州的民主党初选中投票。

音频伪造的速度与成本: 根据对克莱默的诉讼,制作这个深度伪造音频仅耗时不到20分钟,成本仅为1美元。克莱默告诉哥伦比亚广播公司新闻(CBS News),他的这番操作让他获得了“价值500万美元的曝光度”。

语音内容的危险信号: 研究新兴技术和虚假信息的林赛·戈尔曼(Lindsay Gorman)告诉 NBC 新闻,深度伪造通常会有破绽:“其抑扬顿挫,特别是结尾部分,显得不自然、像机器人。这是音频内容可能造假的迹象之一。”

- 语速不自然,缺乏正常的停顿或呼吸声。

- 发音完美无瑕,缺乏自然语音中的瑕疵。

- 某些单词或短语的语调像机器人一样生硬。

- 缺失了本应存在的环境背景噪音。

- 使用了当事人实际上永远不会使用的短语或术语。

语言逻辑漏洞: 早期的一个深度伪造案例显示,AI 说出了“pounds 35,000”(3万5千英镑)——它机械地将货币符号读在数字之前,这种不自然的方式暴露了其合成生成的本质。

30秒危险信号检查:

你可以试试看 Hiya Deepfake Voice Detector,这是一个简单的 Chrome 扩展程序(每月可免费使用20次),可以实时分析音频,判断你听到的是真人的声音还是 AI 生成的。

它的具体功能包括:

- 分析你在 Chrome 浏览器中播放的视频和音频中的声音。

- 即时工作,仅需一秒钟的音频即可做出判断。

- 适用于任何网站——社交媒体平台、新闻网站、视频平台。

- 检测由所有主流 AI 语音合成工具生成的类人语音。

- 支持多种语言。

- 在你浏览网页时实时运行。

注意:由于该插件使用概率算法,它无法保证在每种情况下都 100% 准确。

五分钟技术核实(适用于常规报道):

- 听辨语音自然度 — 语速和发音是否感觉像真人?

- 核实可能性 — 当事人是否真的可能在声称的时间地点发表此声明?

- 检查情感真实度 — 情感是否与内容和语境相符?

- 回拨官方号码 — 对任何紧急的音频请求,都要回拨官方号码进行核实。

- 询问背景问题 — 询问只有真人才知道的背景问题。

深度调查(适用重磅报道):

- 下载完整的音频片段。

- 将其输入 Notta.ai 并让其生成逐字稿。

- 在等待期间,向 Claude 提供五到六段该人物经过核实的音频片段或逐字稿。

- 要求 Claude 进行语义分析,并对主题、语言模式、语法使用、风格和语调进行分类。

- 然后上传你不信任的音频逐字稿,要求 Claude 对比分析其中的异常之处。

第五类:时序与语境逻辑——当 AI 忽视全局

一张 AI 生成的图像,声称是一则关于巴黎气候抗议的新闻广播静帧。图:Henk van Ess

原理: AI 基于视觉模式生成内容,却并不理解现实世界的语境、时间逻辑或情境适宜性。这就导致生成的内容在孤立状态下看起来令人信服,但经不起常识的推敲。

伊朗监狱视频骗局: 一段制作精良的 AI 生成视频声称展示了以色列导弹袭击伊朗埃温监狱(Evin Prison)的画面,但实际上是基于2023年的一张照片生成的。关键的检测线索包括季节不匹配(所谓的夏季画面中灌木丛却没有叶子)、违反概率的完美细节匹配,以及不可能的时间线。

30秒危险信号检查: AI 能创造出视觉上令人信服的内容,但往往忽略了时间、地点和环境之间的基本逻辑关系。在突发新闻场景中,相信你对世界的常识,以此发现那些本需复杂分析才能证实的“不可能性”。

- 季节/天气合理性检查 — 植被、衣着或光照是否符合声称的日期和地点?

- 技术时间线扫描 — 是否出现了任何不属于该时间段的设备、车辆或基础设施?

- 地理直觉检查 — 建筑、标牌和景观是否符合声称的地点?

- 来源可信度快速评估 — 内容的来源是否与其复杂程度和获取难度相符?

五分钟技术核实(适用于常规报道): 这种更深入的分析利用你的研究技能,将声称的内容与可核实的事实进行交叉引用。AI 难以处理现实世界事件之间相互关联的本质,生成的内容或许能通过视觉检查,但在与外部数据源对比时,往往无法通过逻辑审查。

- 历史天气核实 — 查阅声称日期/地点的历史天气数据,与画面中的可见条件进行对比。

- 建筑地标交叉引用 — 核实可见的建筑物、标志和基础设施是否确实存在于声称的地点。

- 文化元素审计 — 确认服装风格、行为举止和社会动态是否符合地理/文化背景。

- 时间线概率评估 — 研究声称的事件在逻辑上是否可能同时发生。

- 来源模式分析 — 绘制内容传播路径,并与类似事件的典型传播模式进行对比。

- 多角度搜索 — 寻找来自独立来源的同一事件的其他记录。

深度调查(适用于高风险报道): 对于关键报道,将语境线索视为法医拼图中的碎片,每一块都需要针对既定事实进行系统性核实。这种综合方法基于多个逻辑不一致点建立概率矩阵,而不是依赖单一的确凿证据点。

- 综合时间线重建 — 建立声称事件的详细时间表,并交叉引用所有视觉元素。

- 地理情报核实 — 利用卫星图像、街景和本地专业知识确认地点细节。

- 季节/环境取证 — 就环境条件咨询植物学专家、气象学家和当地消息人士。

- 文化真实性评估 — 采访区域专家,了解内容中可见的行为规范、着装规范和社会习俗。

- 技术时代错乱分析 — 核实所有可见的设备、车辆、基础设施是否在声称的时间和地点存在。

- 来源链调查 — 追踪完整的传播历史,并与类似的真实事件模式进行比较。

- 专家咨询网络 — 咨询熟悉声称地点或情况的当地记者、学者和官员。

- 概率矩阵构建 — 对每个逻辑元素进行评分,并构建内容真实性的综合评估。

第六类:行为模式识别——当 AI 搞不懂人类

AI-generatred image purporting to show protesters marching in a city street. Image: Henk van Ess 一张 AI 生成的图像,声称显示抗议者在城市街道上游行。图片来源:Henk van Ess

原理: AI 可以复制人类的外貌,但在模拟真实的人类行为、社会动力学和自然的互动模式方面却很吃力。这会在人群场景、群体动态和个人行为中产生可检测的不一致性,训练有素的观察者可以发现这些破绽。

30秒危险信号检查(适用于突发新闻): AI 创造的人群乍一看很逼真,但不自然的某些行为模式暴露了其虚假性。在突发新闻情况下,关注人们的表现是否像在特定情况下的真实人类,而不是遵循程序化行为的数字演员。

- 人群统一性扫描 — 是否有太多人年龄、外貌或着装风格相似?

- 注意力模式检查 — 所有人看向同一方向或镜头,还是注意力存在自然的变化?

- 情感真实度直觉检查 — 面部表情是否符合事件声称的情绪和强度?

- 动作真实性评估 — 是自然的人际间隔和肢体语言,还是人工排布的位置?

五分钟技术核实(适用于常规报道): 这种分析利用你对人类社会动力学的理解,识别 AI 在复制真实群体行为方面的缺陷。真实的人群表现出复杂的社会模式,而 AI 训练数据无法完全捕捉这些模式,导致在所谓的自发集会中出现可检测的人工统一性。

- 人口统计多样性审计 — 统计年龄范围、服装风格、种族代表性,对比人工统一性。

- 社会互动映射 — 识别真实的对话、关系和群体动态,对比摆拍式站位。

- 环境反应验证 — 人们对天气、光线、噪音水平的反应是否恰当?

- 文化行为交叉检查 — 社会规范、个人空间和互动风格是否符合声称的背景?

- 个人表情分析 — 寻找独特的面部表情和真实的情感,对比统一或通用的反应。

- 动作模式评估 — 是否存在自然的不对称和个人怪癖,对比人工平滑的动作?

深度调查(适用于重磅报道): 对于重磅报道,将人类行为视为人类学证据,需要对社会模式进行系统分析。这种综合方法审查复杂的人际互动网络是否真的可能在所声称的情况下发生。

- 社会学人群分析 — 咨询人群心理学专家,验证针对声称事件类型的现实群体动态。

- 文化真实性核实 — 采访区域专家,了解适当的社会行为、着装规范和互动模式。

- 人口统计概率评估 — 研究人群构成是否符合类似事件的典型参与模式。

- 个人行为取证 — 分析特定人员是否具有连贯的个性、关系和真实的情感反应。

- 环境适应研究 — 验证人群对天气、声学和后勤的反应是否符合现实世界的模式。

- 历史比对研究 — 与同一地区或文化背景下类似真实事件的经核实录像或照片进行比较。

- 专家咨询网络 — 咨询熟悉区域社会动态的人类学家、社会学家和当地记者。

- 微表情分析 — 咨询专家检查面部表情,区分真实的情感反应与人工生成。

- 社交网络映射 — 追踪个人之间的关系,以验证群体形成的真实性,对比人工组装。

第七类:直觉模式识别——古老的检测系统

一张 AI 生成的图像,声称显示白俄罗斯总统在一次正式会议上不协调地拿着一筒薯条。图片来源:Henk van Ess

原理: 我们的大脑经过数百万年的进化,形成了模式识别能力。AI 的模式来自训练数据和算法过程。当某些东西违反了人类感知中内置的自然预期时,这种直觉往往是技术分析之前最快、最可靠的初步检测器。

现实世界的成功案例: 2019年,社交媒体用户立即标记了一张在佛罗伦萨飓风期间疯传的“街头鲨鱼”图片。虽然技术上处理得当,但观众觉得它在这种情况下显得不对劲。他们的直觉是正确的——反向搜索揭示了这是数字植入。同样,经验丰富的记者能感知到业余录像看起来可疑地像电影大片,或者所谓的自发事件却拥有完美的记录。

有趣的事实:看来这种所谓在飓风中遭遇鲨鱼的事件已经传了十多年了,但只有一个例子得到了证实。

30秒危险信号检查: 在时间紧迫时,请相信你进化形成的模式识别能力。寻找“制作质量悖论”,即业余来源制作出好莱坞级别的内容,或“时间便利性”,即混乱事件被完美记录。你那古老的检测系统通常能在技术分析确认之前发现这些违和之处。

- 第一印象反应 — 这感觉是真实的还是“制作出来的”?(相信你对人类的人工表现产生的不安感,也被称为“恐怖谷”效应。)

- 制作成本悖论 — 业余来源是否与电影级的质量相符(现在8美元就能制造出专业外观的政治丑闻)?

- 时间便利性检查 — 对事件的完美记录是否发生得太快,超出了正常拍摄的可能?

- 情感操纵测试 — 内容是否旨在引发情感反应和快速分享,而不是为了告知读者?

五分钟技术核实(适用于常规报道): 通过检查触发你模式识别能力的具体元素,将直觉感受转化为系统性核实。当你的直觉告诉你有些不对劲时,找出具体是什么违反了自然预期,以此建立逻辑论证。

- 语境逻辑深度检查 — 鉴于现实世界的知识,该场景在实践中是否有意义?

- 来源可信度调查 — 来源是否与内容的复杂程度和获取要求相匹配?

- 叙事便利性分析 — 故事是否与当前的政治或社会紧张局势过于完美地吻合?

- 技术不一致性审计 — 质量、光线或音频是否符合声称的情况?

- 模式违规目录 — 记录触发可疑感觉或语境不可能性的具体元素。

- 来源-内容不匹配评估 — 标记那些来自业余或匿名来源且没有解释的复杂内容。

深度调查(适用于重磅报道): 对于关键报道,将直觉检测作为全面核实的起点。你的模式识别发现了异常;现在系统地检查每个引发怀疑的元素,以建立基于证据的评估。

- 直觉取证 — 记录每一个感觉“不对劲”的元素,并研究为什么每个元素都违反了自然预期。

- 制作悖论调查 — 计算所需的实际资源,并与业余者的假设能力进行比较。

- 语境不可能性分析 — 将场景与现实世界的知识以及专家咨询的见解进行映射对比。

- 情感操纵评估 — 分析内容结构,区分设计好的病毒式触发点与有机的信息分享。

- 技术不一致性深度挖掘 — 逐帧分析质量、光线和音频的不匹配。

- 来源真实性核实 — 调查声称的来源是否真的可能制作出此内容。

- 叙事工程检测 — 检查故事构建是为了人工便利还是自然事件发展。

- 模式违规专家咨询 — 邀请经验丰富的调查员进行独立的直觉评估。

- 信任阈值分析 — 记录当多个元素显得“不对劲”时的情况,并以此为依据拒绝内容,哪怕其技术上看起来合格。

什么时候该相信你的直觉:

- 即使你无法识别具体问题,但多个元素感觉“不对劲”时。

- 当内容引发立即的情感反应,旨在阻止分析时。

- 如果来源、时间或语境引发逻辑问题。

- 当技术质量与制作人的经验水平不匹配时。

- 如果你的大脑检测到了你在实验中演示的那种制作质量悖论或时间便利性。

现实:没有完美的解决方案

最重要的事: 这七大 AI 检测类别和新工具——解剖学破绽、物理违规、技术指纹、语音伪影、语境逻辑、行为模式和直觉识别——为记者提供了一个全面的工具包,以便在截稿压力下评估内容的真实性。结合专业检测工具和更新的编辑标准,我们可以保持可信度。以毒攻毒。用 AI 来检测 AI。并帮助维护我们仅存的共享现实。

出生于荷兰的亨克·范·埃斯(Henk van Ess)正致力于穿透 AI 的迷雾,从数据中发掘故事。他将这一理念应用于调查研究,并开发了 SearchWhisperer 和 AI Researcher 等供公众使用的工具。作为华盛顿邮报、施普林格出版社(Axel Springer)、BBC 和 DPG 等全球新闻编辑室的培训师,他运营着 Digital Digging 网站,将开源情报与 AI 相结合。他还担任波因特学院国际事实核查网络(IFCN)和欧洲事实核查标准网络(EFCSN)的评估员。

出生于荷兰的亨克·范·埃斯(Henk van Ess)正致力于穿透 AI 的迷雾,从数据中发掘故事。他将这一理念应用于调查研究,并开发了 SearchWhisperer 和 AI Researcher 等供公众使用的工具。作为华盛顿邮报、施普林格出版社(Axel Springer)、BBC 和 DPG 等全球新闻编辑室的培训师,他运营着 Digital Digging 网站,将开源情报与 AI 相结合。他还担任波因特学院国际事实核查网络(IFCN)和欧洲事实核查标准网络(EFCSN)的评估员。