图:Shutterstock

将“美国轰炸伊朗对全球油价有何影响?”这类问题抛给主流的人工智能(AI)聊天机器人或搜索引擎,你会得到一连串看似确凿的数据、网站链接和趋势分析。例如,ChatGPT给出的长篇回答会这样开头:“布伦特原油价格一度飙升超过3%,达到每桶81至82美元左右——创下一月以来的新高。”

但如果向新闻机构内部的AI聊天机器人——例如《华盛顿邮报》的“Ask The Post AI”——提出同样的问题,你通常会得到一个提纲挈领式的回答。这个回答会更简洁、更谨慎,并附上其引用的新闻报道缩略图:“截至目前,油价出现波动,全球原油价格下跌约1%,但局势仍不明朗。”

两者最主要的区别在于答案信息来源的可信度。大型语言模型(LLM)AI聊天机器人会搜索几乎整个互联网,包括未经审查的信源。而近几年来,从菲律宾到英国,多家主流新闻机构纷纷推出了内部的生成式AI聊天机器人。这些机器人旨在专门依据自家网站的报道和经过审核的信源数据库来回答读者提问,并通过严格的代码“护栏”来防止外部的虚假信息或偏见渗入。

这类智能新闻交互工具的代表性产品包括:菲律宾新闻网站 Rappler 的 Rai、英国《金融时报》的 Ask FT、福布斯的 Adelaide以及《华盛顿邮报》的Ask The Post AI。

(值得注意的是:这类工具不同于《华尔街日报》、彭博社和雅虎新闻等媒体所推出的AI新闻摘要工具。后者并不回答读者提问,而是通过生成报道的要点总结,来帮助忙碌的读者节省时间。)

所有这些聊天机器人都自称尚处于实验阶段,并且可能会出错。部分原因在于,它们建立在大型语言模型(LLM)的数字基础架构之上,而LLM向来以其偏见、错误和“幻觉”问题而闻名。

但鉴于普遍的网络搜索中充斥着虚假信息、错误归因、无来源观点和偏见等问题,这些新闻聊天机器人有一个共同的崇高目标:为读者提供值得信赖的信息——而由于读者对这些媒体品牌怀有忠诚度,他们本就倾向于信任这些信息。其答案完全生成自新闻机构档案库中经过充分报道和编辑的文章。此外,尽管AI聊天机器人存在潜在缺陷,专家们仍审慎乐观地认为,它们或许能为新闻机构提供一些解决方案,以增强读者互动、触及年轻受众,甚至开辟潜在的订阅变现渠道。

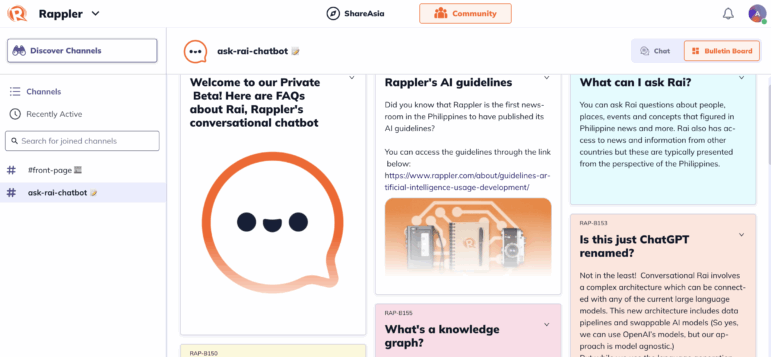

Rappler 新闻网的 Rai 最初是一项低风险的实验:在Rappler聊天室这一相对安全的环境中,充当焦点小组讨论的AI“主持人”。到了2024年10月,它在Rappler的应用程序上成长为一个更具雄心的工具:一个对话式机器人——而非摘要工具——其信息完全来源于Rappler发表过的四十多万篇报道中的事实以及经过审核的数据集。据Rappler数字服务主管杰玛·门多萨(Gemma Mendoza)介绍,这些资料包括Rappler自2011年成立以来发表的超过35万篇文章,其前身《新闻内幕杂志》(Newsbreak Magazine)十年间的深度报道和调查报道,以及菲律宾过去五次全国和地方选举的结果、候选人和选民名册等数据集。

门多萨表示,推出Rai的一个核心目的,是激励读者下载并使用Rappler的移动应用“Rappler社群”(Rappler Communities)。

她问道:“社交媒体确实已经降低了新闻的优先级,那么你该如何与受众互动?如何获得可持续的流量,并让受众参与到你的内容中来?”她接着说:“另一种维持这种关系的方式是通过新闻信,但这在菲律宾并未真正成为一种习惯。我们为自己的应用设定了宏大的互动目标,而Rai正是一种能以更细致入微的方式与用户互动并呈现我们内容的方法。”

理论上,该系统背后的“知识图谱”数据库每15分钟就会将最新的报道和调查文章加入其已归档的报道和信源数据资料库中,然后Rai就能为应用用户提供信息充分且相对及时的回复,并附上几篇相关的报道链接。

门多萨说:“广义上的人工智能存在一个问题,那就是它从四面八方获取信息,并且基本上将每个信息点都等同视之。而在Rappler,我们为自己的报道负责,我们核查事实,而这正是Rai的根基所在。”

然而,新闻编辑室不像商业服务商那样拥有庞大的数据工程团队来维护这些复杂的系统,在新闻机构对话式机器人的这个实验性时代,故障仍然很常见。例如,在7月的几周里,由于更新功能出现问题,Rai未能收录最新的报道,导致一些回答过时。

门多萨称,尽管Rai建立在大型语言模型(LLM)的基础架构之上,但其最新定制版本包含了创新且极其严格的“护栏”,以防止外部信息渗入到结果中。

正如该应用中的解释说明所述:“这与其他聊天机器人不同,它们的数据来源包括各种随机网站,其内容不一定经过审查。毕竟,垃圾进,垃圾出。”

她解释道:“它确实是对话式的——我们在现有的LLM之上创建了一个基础架构;这个架构是与平台无关的,所以如果需要,我们可以决定将其迁移到其他的LLM上。其回答均来源于已发表的报道和结构化数据。”

门多萨补充说:“我们专注于Rappler真正擅长的领域,首先从政治入手。”

聊天机器人的局限性

英国《金融时报》的生成式AI工具“Ask FT”仅对“FT专业版”订阅用户开放,其答案均来源于该报自2004年以来的历史存档。

今年五月,哥伦比亚大学新闻学院专业实践教授比尔·格鲁斯金(Bill Grueskin)对这款聊天机器人进行了测试。他指出,尽管其提供的事实都经过了新闻专业审核,但一些回答很快就暴露了其数据库的局限性。他提到,“它似乎无法回答‘特斯拉在2024年卖了多少辆车?’这样的问题。”

然而,尽管格鲁斯金本人并非AI的常用者,他还是发现了这款聊天机器人的几个优点。

“它的界面很简单,”他说。“你只需在一个框里输入问题——比如‘中美贸易战的最新进展是什么?’——几秒钟内,它就能生成一个周到、准确的摘要式回答,并附上脚注和为其提供信息的《金融时报》报道链接。”

在接受全球深度报道网采访时,格鲁斯金表示,新闻机构的AI模型在增强新闻互动、提升公众知情水平以及改善存档搜索方面,展现了适度的前景。

“总的来说,我确实喜欢这个想法,”他解释道。“原因之一是大多数新闻网站的搜索引擎都糟透了。即便是主流媒体的搜索功能也不尽人意:它们给出的结果很差,还不让你按日期排序。相比之下,当我在谷歌中输入关键词,再加上‘site:nytimes.com’这样的限定词时,搜索结果要好得多。如果AI能改善这种体验,并且答案都源自一个包含了已发表且经过编辑的报道的底层数据库——这个数据库还包括了记者后续所做的任何更正——那就太棒了。”

他补充道:“这一切的前提是,你得确保AI不会凭空捏造引语和事实。”

哈佛大学肯尼迪学院公共利益技术实验室负责人拉坦娅·斯威尼(Latanya Sweeney)博士表示,除了数据库有限之外,新闻机构聊天机器人还有一个潜在问题,即AI程序可能会根据过去的报道,无意中提供具有误导性的答案。例如,关于某个政府部门的回答,可能会因为关于该话题的争议性新闻报道中的事实而产生偏差。她说,一些新闻机构的交互工具最终可能会在单一新闻存档的严格数据限制和由独立新闻机构合作建立的更广泛的互联网存档之间寻求一个中间地带。

她解释说:“如果你存档中的文章在某个话题上非常狭隘,只谈论了其中的一小部分,那么它可能只会从那个角度来回答问题。但外界或许存在一个来源更可靠、更优质的答案。仅仅使用自己的存档有很大的局限性。因此,如果能建立一个由可信新闻档案组成的生态系统(来为AI提供答案),那或许会非常理想。”

专家表示,这些内部聊天机器人针对外部网站设置的数字防火墙极大地降低了它们捏造事实的风险,但并不能完全消除这种风险。

Rappler网站对Rai生成的回答采用其常规的编辑勘误政策,并邀请读者在聊天室或通过电子邮件指出任何可能的错误。该媒体声明:“我们将努力找出错误根源,并在必要时更正源材料。”

对许多用户来说,新闻机构聊天机器人最令人耳目一新、也最能建立信任感的特点之一,是它们有时会用一句“我不知道”来有效回应一个问题。如果你问《华盛顿邮报》的聊天机器人“1922年在伦敦下令暗杀亨利·威尔逊爵士的是谁?”,它会承认:“抱歉,我们无法生成答案。”但ChatGPT则会自信地回答:“很可能是由爱尔兰自由邦临时政府领导人迈克尔·柯林斯下令的,”尽管这一说法在一个引发了爱尔兰内战的事件上极具争议和分歧。

门多萨提醒说:“AI的一个问题是,即使没有经过审核的数据来回答,它也倾向于尝试回答问题,所以必须设置好‘护栏’。因此,Rai懂得如何说‘我不知道这个’,这通常是因为它没有把握能正确理解问题。”

在Rai发布时,Rappler的数据与创新主管唐·凯文·哈帕尔(Don Kevin Hapal)表示,该计划为非营利新闻机构树立了一个可以效仿的榜样:“通过Rai,我们不只是推出了又一个AI工具,我们正在定义新闻编辑室应如何利用数据和AI来建立公众信任。通过将Rai根植于Rappler严谨的新闻操守之上,我们证明了AI可以被负责任地整合,用以在虚假信息面前捍卫真相。”

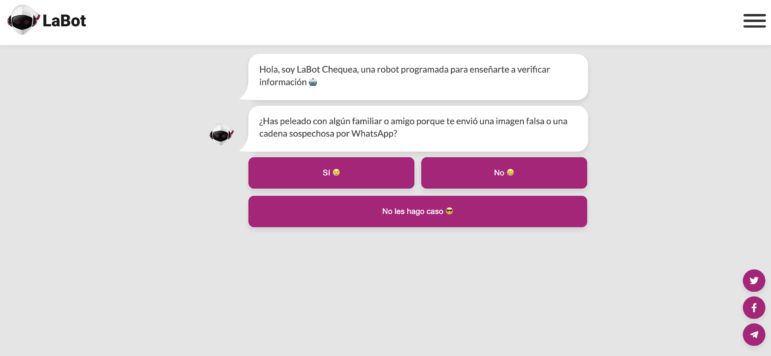

在生成式AI出现之前,一些调查新闻机构曾基于交互式决策树提供新闻问答界面。

一个突出的例子是智利的LaBot。在2017年至2023年间,用户可以通过Telegram或Facebook Messenger,从记者预先写好的一系列预期问题中进行选择,通过点击标签页找到关于该新闻机构自身报道的一系列对话式答案。

LaBot的联合创始人弗朗西斯卡·斯科尼克(Francisca Skoknic)表示,那款实验性聊天机器人的受欢迎程度说明了读者普遍希望就事实进行简短、可信的对话。

斯科尼克说:“我认为这些(新闻机构的AI)聊天机器人是有意义的,因为很多时候,人们没有时间阅读整篇文章,但确实想从一个值得信赖的品牌那里获得具体的答案——特别是如果这个媒体像Rappler一样,拥有关于一个国家时事的全面、经审核的信息。但重要的是,这些工具必须能够说‘我不知道’,而不是试图强行给出答案。聊天机器人可以创造一种情感连接,这与阅读新闻的感觉非常不同。”

内部使用与开发

门多萨表示,这款聊天机器人也帮助了Rappler的记者准备新闻报道。

她指出:“我们的编辑团队一直在大量使用它。例如,我们负责宗教事务的记者会自己为报道做基础研究,但作为一种辅助手段,他会利用Rai帮助他梳理背景资料,整合Rappler已有的信息。”

她补充说:“Rai的一个用例是帮助你处理那些不常关注的议题。关于(前总统)杜特尔特的机密资金问题,已经举行了多场马拉松式的听证会,你需要迅速跟上进度,这时你就可以向Rai询问最新动态。‘关于健康保险基金的担忧有哪些?’‘为什么预算被削减了?’‘新闻里冒出来的这个人物是谁?’你都可以问Rai。”

对于其他考虑推出自有AI聊天机器人的新闻机构,门多萨警告说,让记者深度参与到设计目标中至关重要。

她解释道:“是的,你需要数据工程师和开发人员,并且要分阶段部署这些工具。但重要的是,不能让工程师单打独斗。你需要工程团队和内容团队之间的紧密结合。在这些机器人的工程设计中,你需要一种编辑思维。”

门多萨补充说,新闻机构应首先明确潜在聊天机器人的目的,并清晰地理解这项技术能做什么、不能做什么。

她解释道:“摘要总结功能可以是即插即用的,但对话式聊天机器人并非如此。建立起‘护栏’架构非常重要,否则就有可能凭空捏造信息。”

Rowan Philp 是全球深度报道网(GIJN)的全球记者和影响力编辑。他曾是南非《星期日泰晤士报》的首席记者,在全球二十多个国家报道新闻、政治、腐败和冲突,并曾在英国、美国和非洲的新闻编辑室担任派稿编辑。

Rowan Philp 是全球深度报道网(GIJN)的全球记者和影响力编辑。他曾是南非《星期日泰晤士报》的首席记者,在全球二十多个国家报道新闻、政治、腐败和冲突,并曾在英国、美国和非洲的新闻编辑室担任派稿编辑。